机构名称:

¥ 1.0

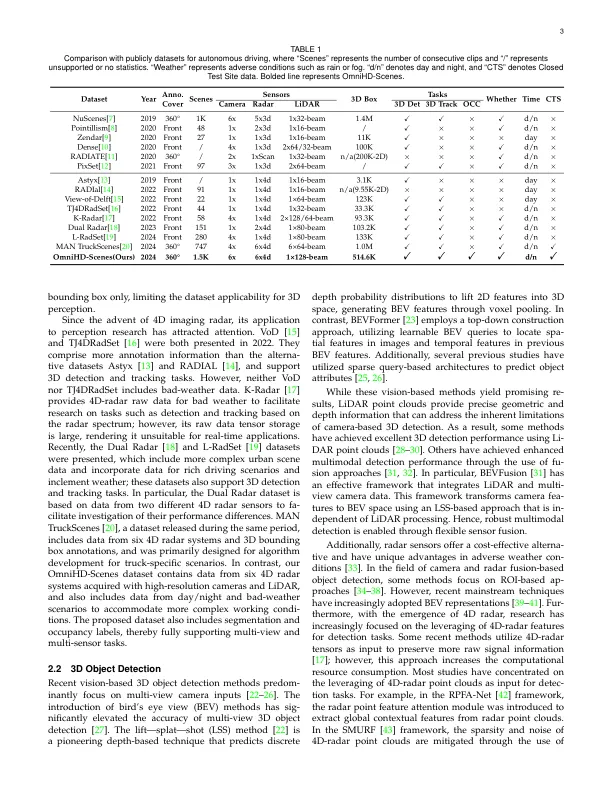

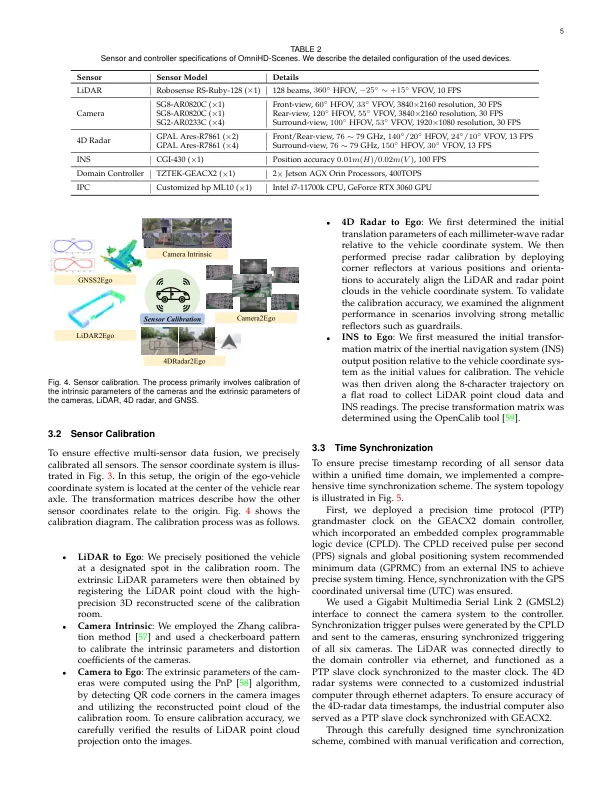

摘要 - 深度学习的快速进步加剧了对自动驾驶算法使用的全面数据的需求。高质量数据集对于开发有效数据驱动的自动驾驶解决方案至关重要。下一代自动驾驶数据集必须是多模式的,结合了来自高级传感器的数据,这些数据具有广泛的数据覆盖率,详细的注释和不同的场景表示形式。为了满足这一需求,我们提出了OmniHd-Scenes,这是一个大规模的多模式数据集,可提供全面的全向高清数据。OMNIHD-SCENES数据集结合了来自128束梁雷达,六个摄像机和六个4D成像雷达系统的数据,以实现完整的环境感知。数据集包含1501个夹子,每个夹子长约30秒,总计超过450K同步帧和超过585万个同步传感器数据点。我们还提出了一个新颖的4D注释管道。迄今为止,我们已经注释了200个剪辑,其中有超过514K精确的3D边界框。这些剪辑还包括静态场景元素的语义分割注释。此外,我们还引入了一条新型的自动化管道,以生成密集的占用地面真理,从而有效利用了非钥匙框架的信息。与拟议的数据集一起,我们为3D检测和语义占用预测建立了全面的评估指标,基线模型和基准。这些基准测试利用环绕摄像机和4D成像雷达来探索用于自动驾驶应用的具有成本效益的传感器解决方案。广泛的实验证明了我们的低成本传感器构型及其在不利条件下的鲁棒性的有效性。数据将在https://www.2077ai.com/omnihd-scenes上发布。

OmniHd-Scenes:用于自动驾驶的下一代多模式数据集

主要关键词