机构名称:

¥ 1.0

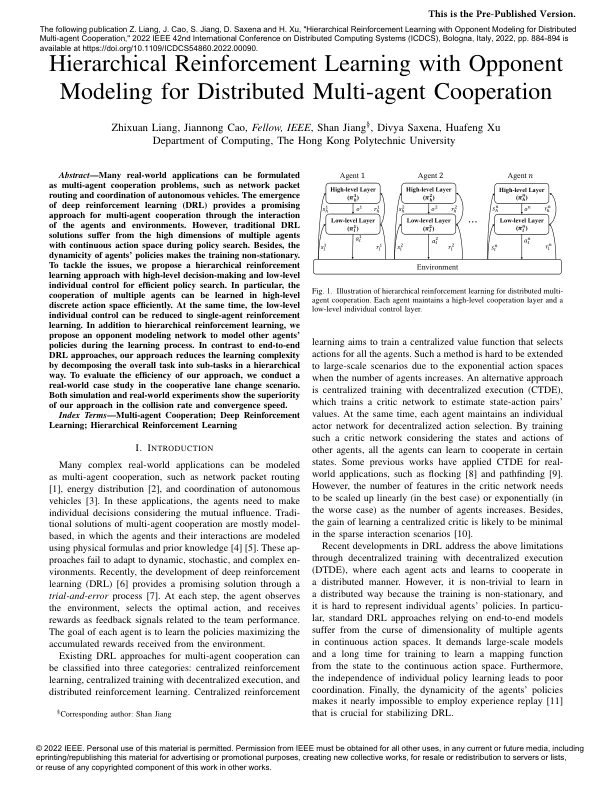

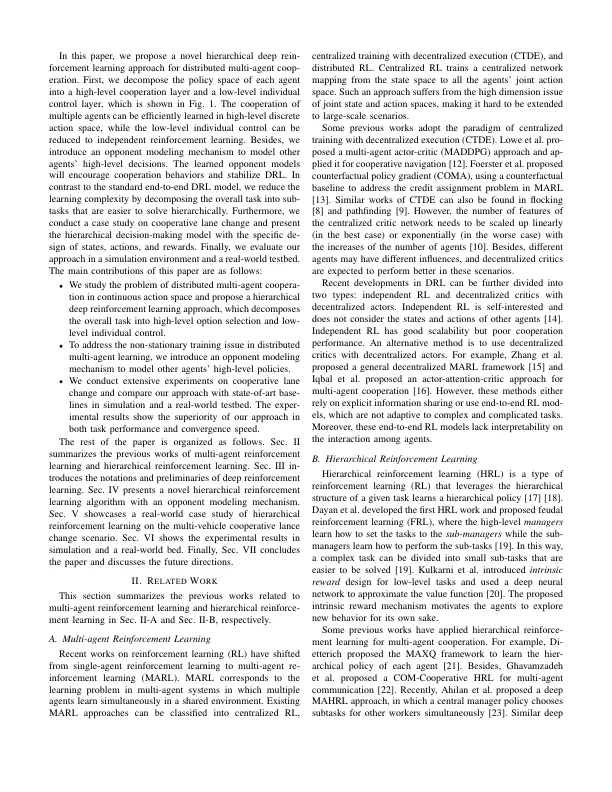

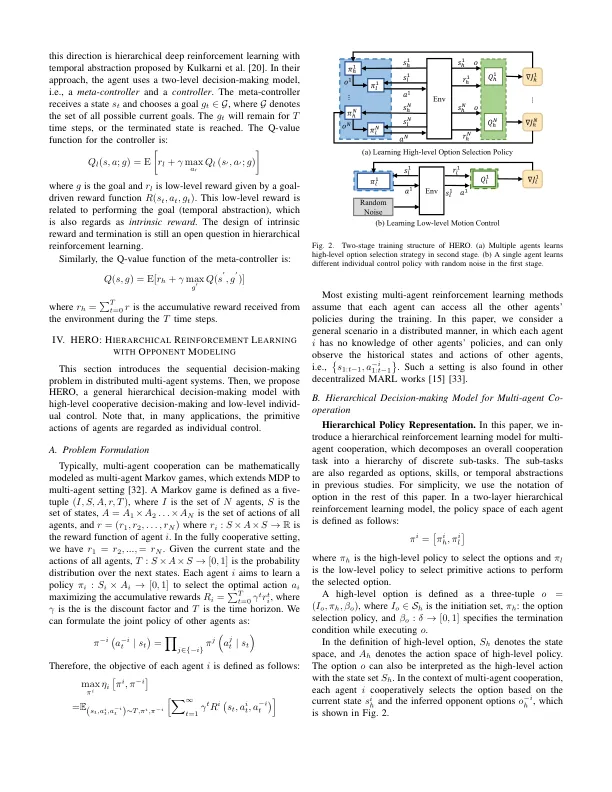

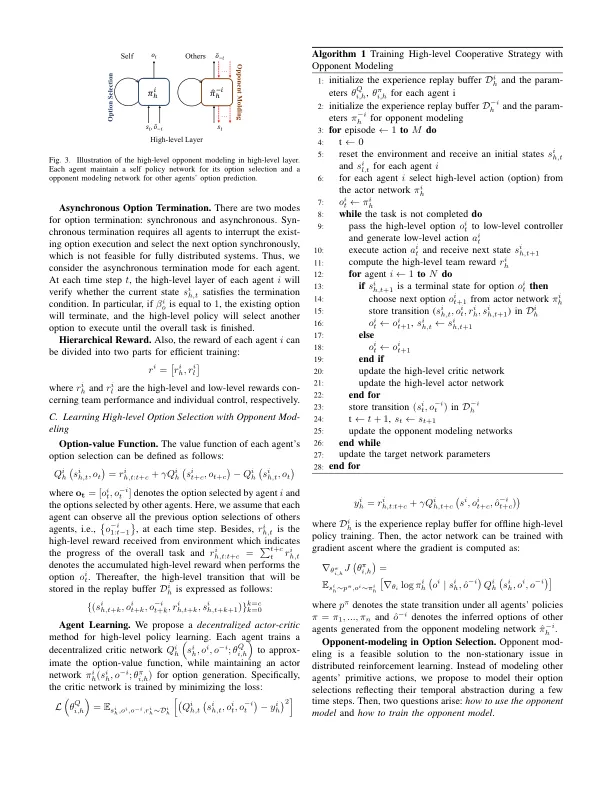

摘要 - 许多现实世界的应用程序可以作为多机构合作问题,例如网络数据包路由和自动驾驶汽车的协调。深入增强学习的出现(DRL)通过代理和环境的相互作用为多机构合作提供了一种有希望的方法。然而,传统的DRL解决方案在策略搜索过程中遭受了具有连续动作空间的多个代理的高维度。此外,代理政策的动态性使训练非平稳。为了解决这些问题,我们建议采用高级决策和低级个人控制,以进行有效的政策搜索。特别是,可以在高级离散的动作空间中学习多种代理的合作。同时,低级个体控制可以减少为单药强化学习。除了分层增强学习外,我们还建议对手建模网络在学习过程中对其他代理的政策进行建模。与端到端的DRL方法相反,我们的方法通过以层次结构将总体任务分解为子任务来降低学习复杂性。为了评估我们方法的效率,我们在合作巷更改方案中进行了现实世界中的案例研究。模拟和现实世界实验都显示了我们在碰撞速度和收敛速度中的优越性。索引条款 - 多机构合作;深入的强化学习;分层增强学习

层次的强化学习与对手建模用于分布式多代理合作

主要关键词