机构名称:

¥ 1.0

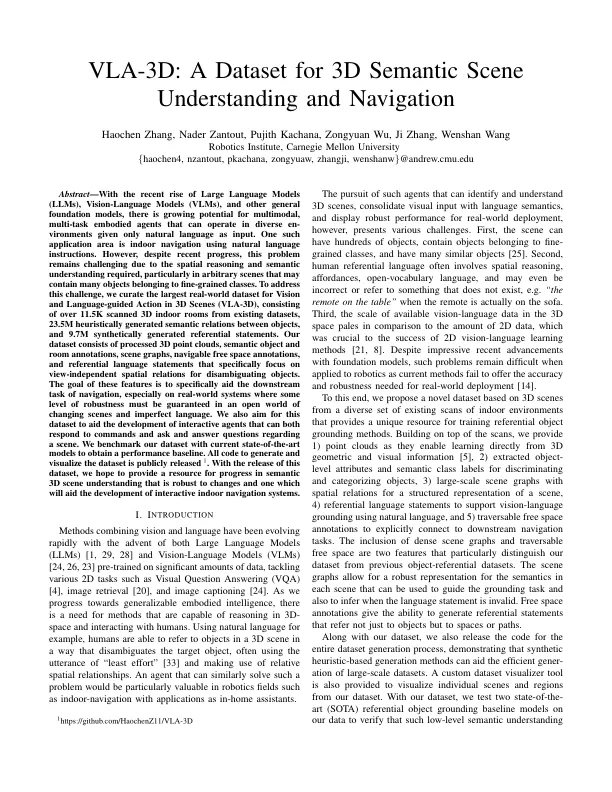

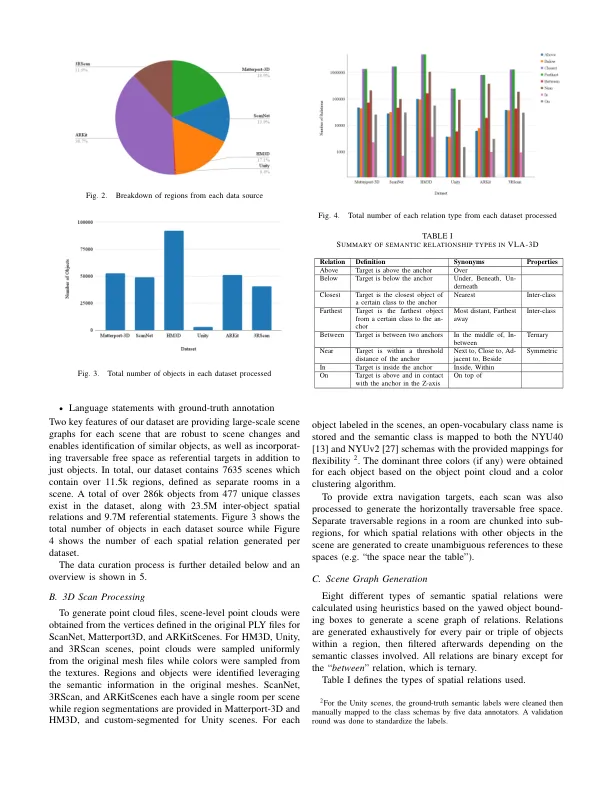

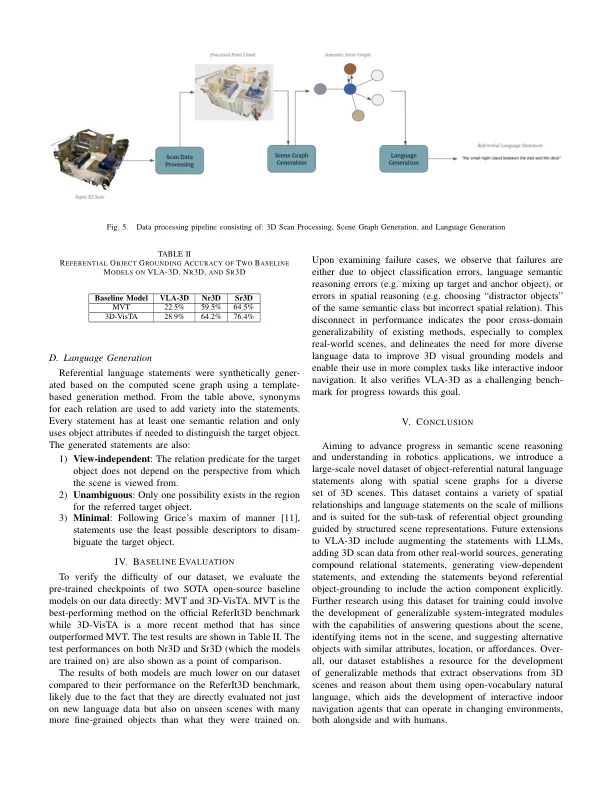

摘要 - 随着大型语言模型(LLM),视觉模型(VLM)和其他一般基础模型的最新兴起,多模式,多任务体现的代理的潜力越来越大,可以在不同的环境中以自然语言作为输入来运作。一个这样的应用区是使用自然语言说明的室内导航。尽管最近进展,但由于所需的空间推理和语义理解,该问题仍然具有挑战性,尤其是在可能包含许多属于细粒类的对象的任意场景中。为了应对这一挑战,我们策划了3D场景(VLA-3D)的视觉和语言引导动作的最大现实世界数据集(VLA-3D),包括超过11.5k的现有数据集中的3D室内室内室内,2350万个启发式化的启发式化的启发式语义生成的语义关系,对象之间,综合构成了综合典型的参考性。我们的数据集由处理过的3D点云,语义对象和房间注释,场景图,可通航的自由空间注释以及参考语言语句,这些语言语言专门针对独立于视图的空间关系,以消除歧义对象。这些功能的目标是专门帮助导航的下游任务,尤其是在现实系统中,必须在不断变化的场景和不完美的语言的开放世界中保证某种级别的鲁棒性。我们还旨在使该数据集有助于开发交互式代理,这些互动代理都可以响应命令并提出有关场景的问题并回答问题。我们使用当前的最新模型基准测试数据集,以获得性能基线。所有要生成和可视化数据集的代码均公开发布1。随着该数据集的发布,我们希望为语义3D场景中的进度提供资源,这对变化是可靠的,这将有助于开发交互式室内导航系统。

VLA-3D:用于3D语义场景的数据集理解和导航

主要关键词